O guia definitivo sobre visão computacional: das imagens à inteligência de processos

De câmeras de segurança a exames médicos complexos, no mundo atual o volume de dados gerados por imagens e vídeos é enorme. No entanto, para um computador, uma imagem não é uma cena com cores e formas; é apenas uma matriz gigantesca de números.

E é justamente a visão computacional a disciplina que preenche essa lacuna entre dados e o visual, permitindo que máquinas não apenas "vejam", mas compreendam o que está acontecendo em uma cena.

Em 2026, essa tecnologia é o motor de inovações que salvam vidas em hospitais e otimizam a produtividade no campo. E os profissionais das mais diversas áreas já estão vendo isso.

Segundo o Panorama do Desenvolvimento Profissional no Brasil (Alura/Opinion Box), 76% dos profissionais acreditam que o conhecimento tecnológico será o fator decisivo para o futuro de suas carreiras, e a visão computacional está no centro dessa transformação.

E é claro, se você concorda com esse grupo de profissionais, vale muito a pena continuar a leitura!

O que é a visão computacional?

De uma forma bem direta, a visão computacional é um subcampo da inteligência artificial (IA) que treina computadores para interpretar e compreender o mundo visual.

Utilizando câmeras, sensores e algoritmos de aprendizado profundo (deep learning), as máquinas buscam replicar a complexidade do sistema visual humano.

Enquanto nós usamos retinas, nervos ópticos e o córtex visual para identificar um objeto instantaneamente, uma máquina precisa processar cada pixel, identificar bordas, texturas e padrões para, então, classificar o que está vendo.

A visão computacional busca automatizar essas tarefas que o sistema visual humano realiza com perfeição, mas com a vantagem da escala, da velocidade e da precisão matemática que não sofre com o cansaço.

Alguns conceitos-chave da visão computacional

Para quem está começando, é comum confundir os termos que orbitam essa área. Vamos organizar a hierarquia desse conhecimento, para não deixar mais dúvidas:

Inteligência artificial

A IA é o guarda-chuva principal. Ela engloba qualquer técnica que permita aos computadores mimetizar o comportamento humano. A visão computacional é um dos braços mais bem-sucedidos da IA.

Machine learning

O aprendizado de máquina é uma subárea da IA que utiliza métodos estatísticos para permitir que as máquinas "aprendam" a partir de dados, sem serem explicitamente programadas para cada tarefa.

Na visão computacional, o machine learning é usado para reconhecer padrões em conjuntos de imagens.

Deep learning

Em veículos autônomos, a visão computacional é essencial para o mapeamento de trajetórias.

Este é o motor da visão computacional moderna. O deep learning utiliza redes neurais profundas (inspiradas na estrutura do cérebro) para processar dados em múltiplas camadas.

É graças ao aprendizado profundo que as máquinas hoje conseguem superar a acurácia humana em tarefas como a classificação de certas doenças em radiografias.

Visão computacional

É a aplicação prática das técnicas acima focada em dados visuais. O objetivo é extrair informações significativas de imagens e vídeos para tomar decisões ou fazer recomendações.

Processamento de imagem

Frequentemente confundido com a visão computacional, o processamento de imagem foca na transformação da imagem (como aumentar o brilho, remover ruído ou redimensionar) para que ela fique melhor para um humano ou para uma etapa posterior de análise.

A visão computacional começa onde o processamento de imagem termina: na interpretação.

Técnicas essenciais em visão computacional

Para que uma IA entenda uma imagem, ela utiliza diferentes técnicas dependendo do objetivo do projeto:

Classificação de imagens

É a tarefa mais básica. O algoritmo recebe uma imagem e atribui um rótulo a ela.

- Exemplo: Um sistema que analisa uma foto e diz se nela há um "gato" ou um "cachorro". É uma resposta binária ou multiclasse para a imagem como um todo.

Detecção de objetos

Vai um passo além da classificação. Além de dizer o que está na imagem, ela indica onde o objeto está, desenhando uma caixa delimitadora (bounding box) ao redor dele.

- Exemplo: Um carro autônomo que detecta pedestres, semáforos e outros veículos na via em tempo real.

Segmentação e rastreamento

A segmentação é o nível mais detalhado. Em vez de uma caixa, ela identifica cada pixel que pertence ao objeto, delineando sua forma exata.

O rastreamento (tracking) é a capacidade de seguir esse objeto ao longo de vários frames de um vídeo.

- Exemplo: Em uma cirurgia robótica, a segmentação identifica exatamente os limites de um tumor para que o corte seja preciso.

Relações entre tarefas

Em sistemas complexos, como sistemas de IA Multimodais, essas tarefas ocorrem simultaneamente.

Um sistema de vigilância inteligente pode primeiro detectar uma pessoa (detecção), identificar quem ela é (reconhecimento facial/classificação) e seguir seus movimentos pela loja (rastreamento).

O que são redes neurais convolucionais (CNN)?

Elas são um tipo especializado de algoritmo de aprendizado profundo (deep learning) projetado especificamente para processar e analisar dados visuais, como imagens e vídeos.

Elas imitam o funcionamento do córtex visual humano para identificar padrões como bordas, texturas, formas e, eventualmente, objetos completos.

Antes das CNNs, era muito difícil para os computadores entenderem a relação espacial entre os pixels. A CNN, que funciona por uma arquitetura de redes neurais em camadas de "filtros" que deslizam sobre a imagem (processo de convolução).

- As primeiras camadas identificam coisas simples, como linhas e bordas.

- As camadas intermediárias começam a reconhecer formas e texturas.

- As camadas finais combinam tudo isso para entender objetos complexos, como um rosto humano ou um modelo de carro.

Essa arquitetura é inspirada na forma como o córtex visual biológico processa informações de maneira hierárquica.

Em 2026, já vemos o avanço dos Vision Transformers (ViTs) de maneira bem cotidiana, que aplicam a lógica dos modelos de linguagem (como o próprio ChatGPT) para imagens, permitindo que a IA entenda o contexto global da cena de forma ainda mais eficiente que as CNNs tradicionais.

Qual é a diferença entre visão computacional e processamento de imagem?

Embora andem de mãos dadas, as metas são distintas. Imagine que você tem uma foto de um documento borrado:

- Processamento de imagem: você usa um filtro de nitidez para tornar as letras mais legíveis. O output é uma imagem melhorada.

- Visão computacional: você usa um algoritmo de OCR (Optical Character Recognition) para ler o que está escrito e transformar em texto digital. O output é a informação extraída.

Hoje, o processamento de imagem é visto como uma etapa de pré-processamento essencial para que os modelos de visão computacional tenham um desempenho melhor.

Casos de uso de visão computacional

A visão computacional está redefinindo o que é possível em diversos setores. Veja onde isso se manifesta:

- Saúde: diagnóstico auxiliado por computador. Aqui as IAs analisam raios-X, tomografias e exames de retina para detectar precocemente doenças como câncer e pneumonia com precisão superior à média humana.

- Varejo: lojas autônomas (como o conceito Just Walk Out). Câmeras rastreiam quais produtos você coloca no carrinho e cobram automaticamente na saída, sem filas.

- Agricultura: drones monitoram plantações para identificar pragas, falta de nutrientes ou estresse hídrico em áreas específicas, permitindo o uso direcionado de defensivos agrícolas.

- Segurança: reconhecimento facial e detecção de comportamentos anômalos em aeroportos ou grandes eventos para garantir a segurança pública.

- Indústria: controle de qualidade automatizado. Câmeras em linhas de montagem detectam microfissuras em peças que passariam despercebidas pelo olho humano.

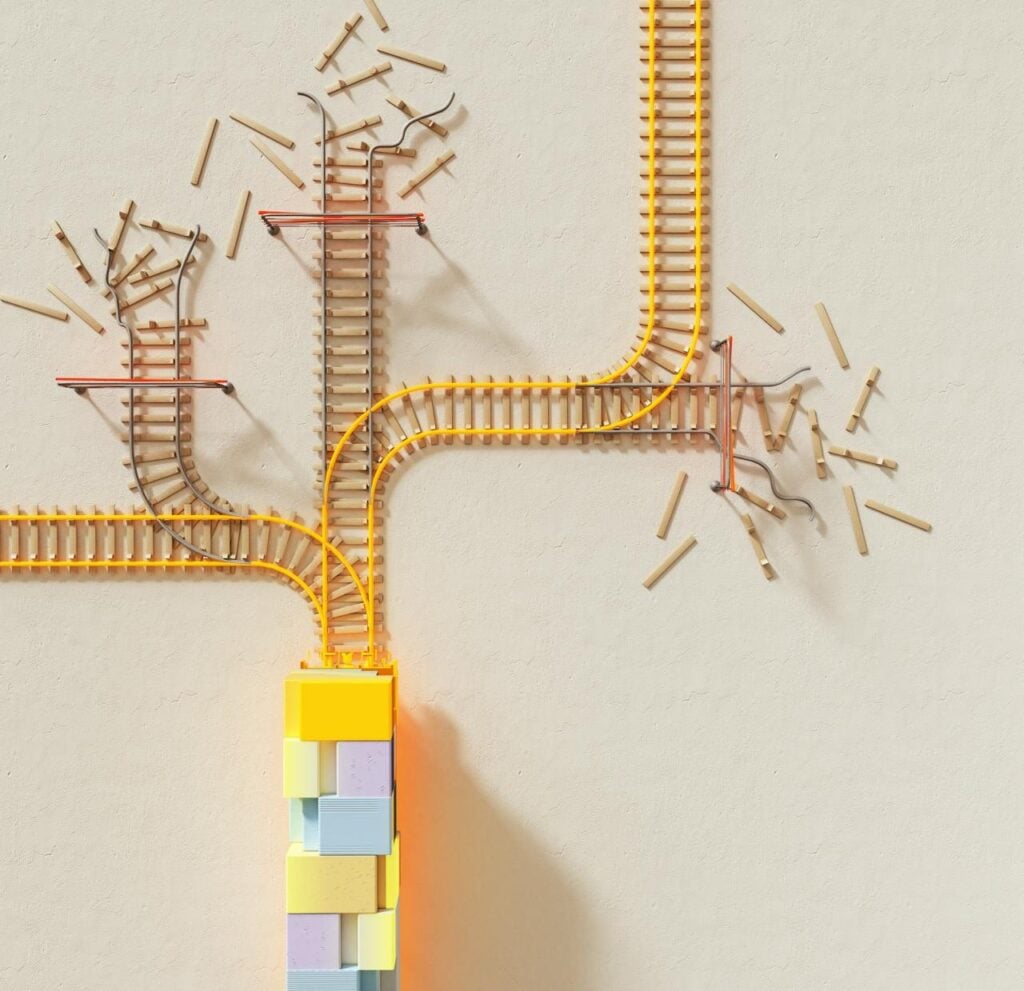

Como funciona a visão computacional em um ciclo de processamento?

Construir um sistema de visão computacional exige uma metodologia rigorosa, seguindo o que chamamos de pipeline de dados e modelos:

1. Coleta de dados

Nenhum modelo aprende sem exemplos. Nesta fase, reunimos milhares de imagens e vídeos que representam o problema que queremos resolver em um banco de dados.

2. Anotação

Esta é a fase mais crítica. Humanos (ou IAs auxiliares) precisam "ensinar" o que está na imagem, desenhando as caixas ou colorindo os pixels. Se a anotação for ruim, o modelo será ruim.

3. Pré-processamento

Aqui aplicamos técnicas de processamento de imagem: redimensionamento, normalização de cores e data augmentation (criar variações das imagens, como girar ou espelhar, para que o modelo aprenda a reconhecer o objeto em qualquer posição).

4. Treinamento

O modelo processa as imagens anotadas e ajusta seus pesos internos para minimizar os erros. É onde a "mágica" das redes neurais acontece.

5. Validação e implantação

Testamos o modelo com imagens que ele nunca viu antes para garantir que ele aprendeu a generalizar e não apenas decorou os exemplos. Se aprovado, o modelo é implantado (deploy) em um aplicativo, câmera ou servidor.

6. Monitoramento

O mundo muda. Uma IA treinada para reconhecer carros de dia pode falhar à noite. O monitoramento contínuo garante que o modelo seja retreinado conforme necessário.

Ferramentas, frameworks e ecossistema

Para colocar tudo isso em prática, a comunidade de tecnologia desenvolveu ferramentas poderosas que facilitam o trabalho de desenvolvedores e cientistas de dados:

- OpenCV: a biblioteca veterana e mais completa para processamento de imagem e visão computacional em tempo real. Essencial para manipular frames de vídeo.

- TensorFlow e Keras: desenvolvidos pelo Google, são amplamente usados para construir e treinar redes neurais complexas de forma escalável.

- PyTorch: criado pela Meta (Facebook), é o favorito da academia e de quem busca prototipagem rápida e flexibilidade no design de modelos.

- YOLO (You Only Look Once): um algoritmo revolucionário para detecção de objetos em tempo real que consegue processar vídeos em altíssima velocidade.

- Scikit-image: uma biblioteca em Python focada em algoritmos tradicionais de processamento de imagem, excelente para quem está começando.

Por que a visão computacional é importante?

O reconhecimento de padrões e a contagem de objetos são tarefas executadas com precisão sobre-humana.

A visão computacional é a tecnologia que dá autonomia às máquinas.

Sem ela, a robótica estaria limitada a movimentos repetitivos e pré-programados. Com ela, robôs podem navegar em armazéns logísticos e carros podem dirigir sozinhos.

Além disso, ela resolve o problema da fadiga humana: uma IA mantém o mesmo padrão de rigor em cada milissegundo de operação.

Guia para quem está começando

Se você quer entrar nessa área, o caminho é prático. A visão computacional exige uma base sólida em Python e matemática linear (matrizes).

Passos práticos

- Aprenda o básico de Python: É a linguagem padrão do ecossistema.

- Entenda como imagens são armazenadas: estude os canais RGB e como uma imagem é uma matriz de números.

- Domine o OpenCV: comece carregando imagens, trocando cores e detectando bordas.

- Crie seu primeiro classificador: use conjuntos de dados famosos como o MNIST (dígitos escritos à mão) ou o CIFAR-10.

Código de exemplo (Python + OpenCV)

Veja como é simples carregar uma imagem e convertê-la para tons de cinza, o primeiro passo para muitas análises:

Python

import cv2

# Carrega a imagem

imagem = cv2.imread('foto.jpg')

# Converte para tons de cinza (simplifica o processamento)

imagem_cinza = cv2.cvtColor(imagem, cv2.COLOR_BGR2GRAY)

# Mostra o resultado

cv2.imshow('Imagem em Tons de Cinza', imagem_cinza)

cv2.waitKey(0)

cv2.destroyAllWindows()Glossário rápido de visão computacional

Para caso tenha se perdido em algum dos termos e queira revisar, montamos uma lista para não se perder com os termos novos:

- Pixel: a menor unidade de uma imagem digital.

- Kernel/Filtro: uma matriz menor usada para detectar padrões como bordas.

- Bounding Box: o retângulo que envolve um objeto detectado.

- Overfitting: quando o modelo "decora" as imagens de treino e falha em imagens novas.

- Transfer Learning: técnica de pegar um modelo já treinado (como o ResNet) e adaptá-lo para uma tarefa específica sua.

Construa o seu futuro na tecnologia

A visão computacional não é apenas sobre o futuro; ela é o agora. Dominar essa área permite que você deixe de ser um mero usuário de ferramentas para se tornar um arquiteto de soluções inteligentes.

Se você quer se aprofundar e se tornar um profissional de destaque, as Carreiras em Inteligência Artificial da Alura oferecem o caminho prático, do zero ao avançado.

E para quem busca uma especialização de nível acadêmico e estratégico, os cursos da FIAP são a escolha certa para liderar a inovação em 2026.

Oportunidades em IA não esperam. Comece sua jornada na visão computacional hoje mesmo.

FAQ | Perguntas frequentes sobre visão computacional

Você ainda ficou com algumas dúvidas depois do conteúdo? Calma, confira abaixo as mais frequentes!

1. Qual a diferença entre IA e visão computacional?

IA é o campo geral. Visão computacional é a especialidade focada em interpretar imagens e vídeos.

2. Preciso saber muita matemática?

Para usar as ferramentas, você precisa entender a lógica de matrizes. Para criar novos algoritmos, um conhecimento profundo de cálculo e estatística é necessário.

3. Posso trabalhar com visão computacional sem diploma?

Sim, o mercado valoriza muito o portfólio. Projetos práticos no GitHub demonstrando que você sabe treinar e implantar modelos são fundamentais.