O que é IA Multimodal? a revolução que conecta texto, imagem, áudio e vídeo

Hoje, vamos mergulhar na revolução multimodal que está transformando a forma como interagimos com a tecnologia.

Nos últimos anos, a Inteligência Artificial evoluiu de modelos que processavam apenas um tipo de informação para sistemas que compreendem e geram conteúdo a partir de múltiplas modalidades (texto, imagem, áudio e vídeo), simultaneamente.

Essa capacidade não é apenas uma melhoria incremental; é uma mudança de paradigma.

A ideia para este guia surgiu com o lançamento de modelos como o Gemini Image Generation do Google e o GPT-4o da OpenAI, que causaram uma "febre" com a qualidade na criação de imagens, especialmente as famosas no estilo Studio Ghibli, como mencionei no meu post no LinkedIn.

Mas por que essa repercussão foi tão grande? Porque saímos de um modelo de "telefone sem fio", onde um LLM passava uma ordem para um modelo de difusão de imagem (que nem sempre entendia o recado), para um sistema integrado.

Agora, o próprio "cérebro" da IA controla a criação da imagem pixel por pixel, assim como gera texto palavra por palavra.

Neste guia, vamos explorar desde o conceito básico da IA multimodal até suas aplicações avançadas, os desafios de sua implementação e o que o futuro nos reserva.

O que é IA Multimodal?

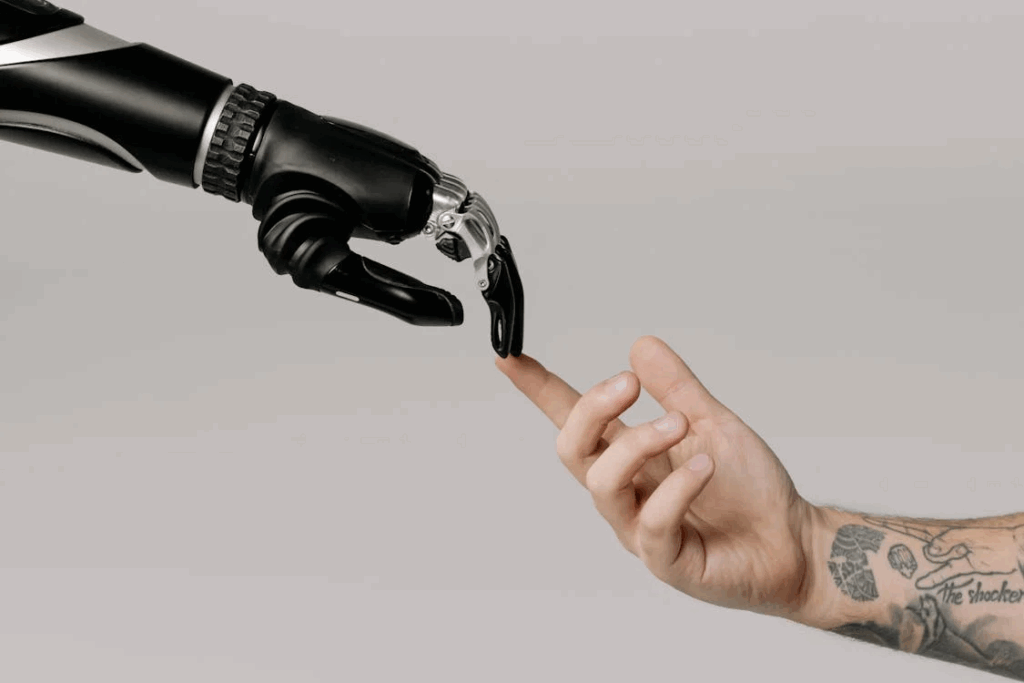

IA multimodal refere-se à capacidade de sistemas de Inteligência Artificial de processar, integrar e gerar informações a partir de múltiplas modalidades de dados, como texto, imagens, áudio e vídeo.

Em vez de um modelo ser treinado para entender apenas um tipo de dado (unimodal), um modelo multimodal consegue "enxergar", "ouvir" e "ler" simultaneamente.

Os modelos tradicionais, como o ChatGPT original (texto-para-texto) ou o DALL-E (texto-para-imagem), eram unimodais em sua função principal.

A grande inovação da IA multimodal é a fusão dessas capacidades em um único sistema.

Imagine um chatbot que não só entende o que você digita, mas também analisa uma foto que você enviou, interpreta as emoções em sua voz e compreende o contexto de um vídeo.

Essa capacidade de cruzar informações e contextualizá-las é o que torna a IA multimodal tão poderosa.

É o que acaba permitindo interações mais naturais e resultados mais robustos, imitando a forma como nós, humanos, usamos nossos múltiplos sentidos para entender o mundo.

Como funciona a IA Multimodal?

A "mágica" da IA multimodal reside na sua arquitetura unificada. O problema dos modelos antigos era o processo de "telefone sem fio":

- Um modelo de linguagem (LLM), o "chefe", interpretava seu pedido (prompt).

- Ele repassava essa interpretação para um segundo modelo, especializado em geração de imagens (um modelo de difusão), o "estagiário".

- O "estagiário" nem sempre entendia 100% o recado. Isso resultava em textos ilegíveis nas imagens ou na falha em entender negações, você pedia "uma cozinha sem gato na pia" e ganhava um gato exatamente onde não queria.

Com a IA multimodal de nova geração, esse cenário mudou.

Agora, o "cérebro" da IA, o próprio LLM, está no comando da criação da imagem do começo ao fim.

Ele "desenha" a imagem pixel por pixel, da esquerda para a direita, assim como gera um texto palavra por palavra.

Tecnicamente, acredita-se que a base para esses avanços esteja em técnicas inspiradas em artigos como o "Transfusion" da Meta.

A ideia central é usar uma arquitetura Transformer unificada que seja eficiente tanto para dados sequenciais (texto) quanto para dados visuais (pixels).

Isso é possível através de alguns conceitos-chave:

- Representação unificada: Em vez de ter sistemas separados, a IA multimodal cria um "espaço de representação comum". "Tokenizadores" avançados transformam informações visuais e de áudio em formatos que o modelo pode processar junto com o texto.

- Mecanismos de atenção cruzada: A arquitetura Transformer permite que o modelo "preste atenção" a partes específicas da entrada. Em um cenário multimodal, ele pode focar em uma palavra do prompt enquanto gera uma área específica da imagem, garantindo coerência.

- Geração integrada: A geração de conteúdo é iterativa e unificada. O modelo constrói a imagem pedacinho por pedacinho, o que permite um controle granular sem precedentes, incluindo a capacidade de gerar textos legíveis dentro das imagens.

- Treinamento turbinado: Esses modelos são treinados com conjuntos de dados massivos e misturados (texto puro, imagens puras, pares de texto-imagem), permitindo que aprendam a correlacionar todas essas modalidades dentro da mesma arquitetura.

Essa abordagem unificada resulta em um nível de precisão que nos permite refinar imagens por meio de um diálogo contínuo, como no trecho do vídeo a seguir, quando falamos sobre ajustar detalhes de um quarto ou criar protótipos de apps:

Tecnologias que Potencializam a IA Multimodal

A IA multimodal é a convergência de várias áreas da Inteligência Artificial que evoluíram significativamente.

A integração delas é o que permite seu funcionamento.

Aprendizagem profunda (Deep Learning)

O deep learning é o motor por trás da revolução da IA generativa. A arquitetura Transformer é a peça dominante aqui.

Originalmente criada para NLP, ela se mostrou incrivelmente eficaz em processar sequências de dados, sejam elas palavras, pixels ou amostras de áudio.

Seus mecanismos de "atenção" são fundamentais para permitir que o modelo entenda o contexto e as relações entre diferentes modalidades.

Processamento de linguagem natural (NLP)

O NLP é a ponte entre a comunicação humana e a compreensão computacional; é a espinha dorsal da interação.

No contexto multimodal, o NLP é responsável por:

- Compreensão de prompts: traduzir as instruções complexas dos usuários em representações que o modelo visual possa processar.

- Geração de descrições: criar legendas para imagens, resumir vídeos ou gerar respostas textuais contextualmente relevantes.

- Análise semântica: entender o significado e a intenção por trás do texto, crucial para que a IA gere resultados alinhados com o desejo do usuário.

Visão computacional

É o campo que confere aos computadores a capacidade de "ver", processar e interpretar imagens e vídeos. Na IA multimodal, a visão computacional atua em duas frentes:

- Análise de entrada: ao receber uma imagem (seja uma foto real ou um rabisco de protótipo), ela identifica objetos, pessoas, cenários e padrões.

- Geração de saída: ela guia o processo de criação de imagens, garantindo que os elementos visuais sejam coerentes, realistas e correspondam às instruções do prompt (como a capacidade de gerar textos legíveis).

Além desses, o Processamento de Áudio e Vídeo também são pilares cruciais, permitindo que a IA "ouça" e compreenda a fala, identifique sons e analise conteúdo em movimento, integrando todas essas percepções.

Aplicações práticas da IA Multimodal

A capacidade da IA multimodal de integrar diversas formas de informação está abrindo possibilidades em quase todos os setores, otimizando processos e impulsionando a transformação digital.

Saúde e biomedicina

A área da saúde é uma das mais promissoras. Modelos multimodais podem levar a diagnósticos mais precisos e tratamentos personalizados.

- Diagnóstico Aprimorado: Um modelo pode analisar simultaneamente imagens médicas (raio-x, ressonância), dados de prontuários eletrônicos (texto) e sinais vitais (dados numéricos de sensores). Ao correlacionar essas fontes, ele pode identificar anomalias sutis que um humano poderia perder.

- Descoberta de Medicamentos: A integração de dados genômicos, estruturas moleculares (imagens) e resultados de experimentos (texto) pode acelerar a identificação de novos alvos terapêuticos.

- Monitoramento Personalizado: Sensores vestíveis, combinados com interações de voz e texto, podem oferecer monitoramento proativo e planos de cuidado altamente personalizados.

Carros autônomos

Veículos autônomos são sistemas inteligentes que dependem intrinsecamente da IA multimodal para operar com segurança.

- Percepção do Ambiente: Eles utilizam uma vasta gama de sensores — câmeras (visão computacional), LiDAR (dados 3D), radares e sensores ultrassônicos. A IA multimodal integra esses dados multimodais em tempo real para criar uma compreensão completa do ambiente.

- Tomada de Decisão: Com base nessa percepção integrada, a IA prevê o comportamento de outros motoristas e pedestres, navega pelo trânsito e reage a situações inesperadas.

- Interação com o Usuário: Futuramente, passageiros poderão dar comandos de voz, apontar para destinos em um mapa (gestos) e receber informações visuais e auditivas de forma natural.

Entretenimento e mídia

Na mídia, a transformação é visível, desde a criação de conteúdo até a personalização da experiência.

- Criação de Conteúdo: A IA que cria imagem e vídeo a partir de texto é um dos maiores avanços. É possível gerar personagens, cenários, storyboards e ilustrações com um nível de controle inédito.

- Experiências Imersivas: Em games e realidade virtual/aumentada, a IA multimodal pode criar ambientes dinâmicos que reagem à voz, gestos e até emoções dos usuários, gerando interações mais realistas.

- Personalização de Mídia: Plataformas de streaming podem usar a IA multimodal para analisar preferências (textos, vídeos, áudios) e recomendar conteúdo com muito mais precisão, impulsionando a análise preditiva e o engajamento.

Desafios da implementação da IA Multimodal

Apesar do imenso potencial, a implementação da IA multimodal apresenta desafios tecnológicos, éticos e operacionais significativos.

- Complexidade e heterogeneidade dos dados: O maior desafio técnico é integrar formatos tão distintos (texto, pixels, ondas sonoras) em uma representação unificada. Além disso, treinar esses modelos exige volumes massivos de dados multimodais rotulados, cuja curadoria e processamento em escala de petabytes são um gargalo.

- Recursos computacionais e custo: Modelos de larga escala como GPT-4o e Gemini demandam poder computacional massivo. Isso se traduz em custos elevados com GPUs de ponta e infraestrutura de nuvem, uma barreira para muitas empresas. O tempo e a energia gastos no treinamento também levantam preocupações ambientais.

- Transparência e explicabilidade ("black box"): Muitos modelos multimodais são "caixas pretas". É difícil entender como eles chegam a certas decisões, especialmente quando várias modalidades são combinadas. A falta de transparência dificulta a auditoria e a construção de confiança em aplicações de alto risco, como saúde.

- Viés e equidade: Se os dados de treinamento contiverem vieses (sociais, culturais, demográficos), a IA os replicará. Isso pode levar a resultados injustos, como na identificação de pessoas em imagens ou na interpretação de comandos de voz de diferentes sotaques.

- Propriedade Intelectual e Direitos Autorais: A origem dos dados de treinamento é uma preocupação. Como fica o uso de imagens e textos protegidos por direitos autorais? E quem detém a propriedade do conteúdo gerado pela IA? A capacidade de replicar estilos artísticos levanta questões sobre autoria e compensação.

- Segurança e Deepfakes: A facilidade de gerar imagens e vídeos convincentes intensifica o risco de deepfakes e desinformação. Isso exige o desenvolvimento de ferramentas de cibersegurança, que detectem e adotemde uma postura de "ceticismo crítico", como sempre reforço no IA Sob Controle.

O futuro da IA Multimodal

A IA multimodal está apenas começando. O futuro da IA promete uma integração ainda mais profunda com o mundo real e um impacto transformador.

Integração com Tecnologias Emergentes

O próximo passo é a integração com outras tecnologias emergentes para criar sistemas inteligentes ainda mais sofisticados.

- IA de vídeo e 3D: O próximo grande avanço será a compreensão e geração de vídeo e modelos 3D de forma nativa. Isso revolucionará a robótica (navegação autônoma), a indústria automotiva (direção autônoma) e o entretenimento (criação de conteúdo imersivo). A NVIDIA, por exemplo, já expande sua plataforma NeMo para suportar o desenvolvimento de modelos de vídeo.

- Robótica e interação física: A combinação da IA multimodal com robótica permitirá que robôs percebam o ambiente de forma mais humana (visão, audição, tato) e compreendam comandos complexos (voz, gestos), executando tarefas com maior autonomia.

- Realidade aumentada (RA) e virtual (RV): A IA multimodal será crucial para criar experiências de RA/RV imersivas, com conteúdo gerado em tempo real que se adapta ao ambiente físico e às interações do usuário.

- Sensores e IoT (Internet das Coisas): A integração com sensores de IoT permitirá que a IA processe dados em tempo real de ambientes físicos, desde cidades inteligentes até monitoramento ambiental, melhorando a eficiência operacional.

Ética e Responsabilidade na IA Multimodal

Com um poder tão transformador, vêm grandes responsabilidades. À medida que a inteligência computacional avança, a discussão ética e de governança precisa acompanhar o ritmo.

Será importante desenvolver ferramentas avançadas de detecção de conteúdo gerado por IA, promover a alfabetização digital e estabelecer regulamentações robustas para garantir que essa tecnologia seja usada para o bem da humanidade.

A transparência e a explicabilidade serão vitais para construir confiança e permitir a responsabilização.

Construa sua carreira no coração da revolução Multimodal!

A revolução multimodal está redefinindo o cenário da Inteligência Artificial, criando um mundo de novas oportunidades de carreira para profissionais que dominam essas tecnologias emergentes.

Se você quer ser um dos arquitetos do futuro, o momento de agir é agora.

Para navegar neste cenário e se destacar no mercado de soluções de IA, você precisa de uma base sólida e do aprendizado contínuo que a tecnologia exige.

Nossos cursos cobrem as linguagens de programação e frameworks que impulsionam os modelos multimodais, preparando você para entender como eles são construídos.

Nossa trilha de aprendizado focada em IA generativa permite que você explore ferramentas como o ChatGPT e o Gemini, aprendendo a criar IA que cria imagem, texto e outras mídias.

Graduações em IA

Com a Graduação em IA e os cursos de Pós-Graduação (Pós-Tech) em Inteligência Artificial, a FIAP oferece um currículo que combina profundidade técnica com uma visão de negócios e inovação.

Não fique para trás. O mercado de trabalho está clamando por profissionais com essas habilidades.Acesse a Escola de Inteligência Artificial da Alura e conheça os cursos de IA da FIAP. Invista no seu futuro e prepare-se para ser parte da elite que está moldando o amanhã. O controle do futuro da IA está em suas mãos.

FAQ | Perguntas frequentes sobre IA Multimodal

1. Empresas menores podem usar IA multimodal sem infraestrutura pesada?

Podem, sim. Hoje, é possível acessar APIs de grandes modelos multimodais (como GPT-4o ou Gemini 2.0) sem precisar treinar nada do zero. Outra opção são os modelos open-source otimizados, como o LLaVA e o CLIP, que permitem personalização com dados próprios e uso local. O segredo é começar pequeno: testar casos de uso reais e medir impacto antes de escalar.

2. A IA multimodal pode substituir profissionais criativos?

Não, ela tende a atuar como coprodutora. A força da IA multimodal está em acelerar etapas repetitivas e oferecer referências visuais, mas a direção criativa e a curadoria humana continuam essenciais. Designers, roteiristas e publicitários que aprendem a dirigir a IA por meio de prompts e refinamentos passam a produzir com mais agilidade e qualidade.

3. Quais habilidades profissionais serão mais valorizadas com a chegada da IA multimodal?

As mais valorizadas combinam técnica e contexto humano:

- Engenharia de prompting e design de interações multimodais;

- Interpretação de dados visuais e linguísticos;

- Ética e governança em IA;

- Conhecimento de linguagens como Python e frameworks de deep learning;

- E, principalmente, pensamento crítico para usar a IA de forma responsável.

O diferencial não será competir com a IA, mas saber orquestrá-la.